Armi di distruzione matematica (Cathy O’Neil)

Quando l’algoritmo diventa ingiusto senza che ce ne accorgiamo

(Recensione e riflessioni ispirate al libro di Cathy O’Neil)

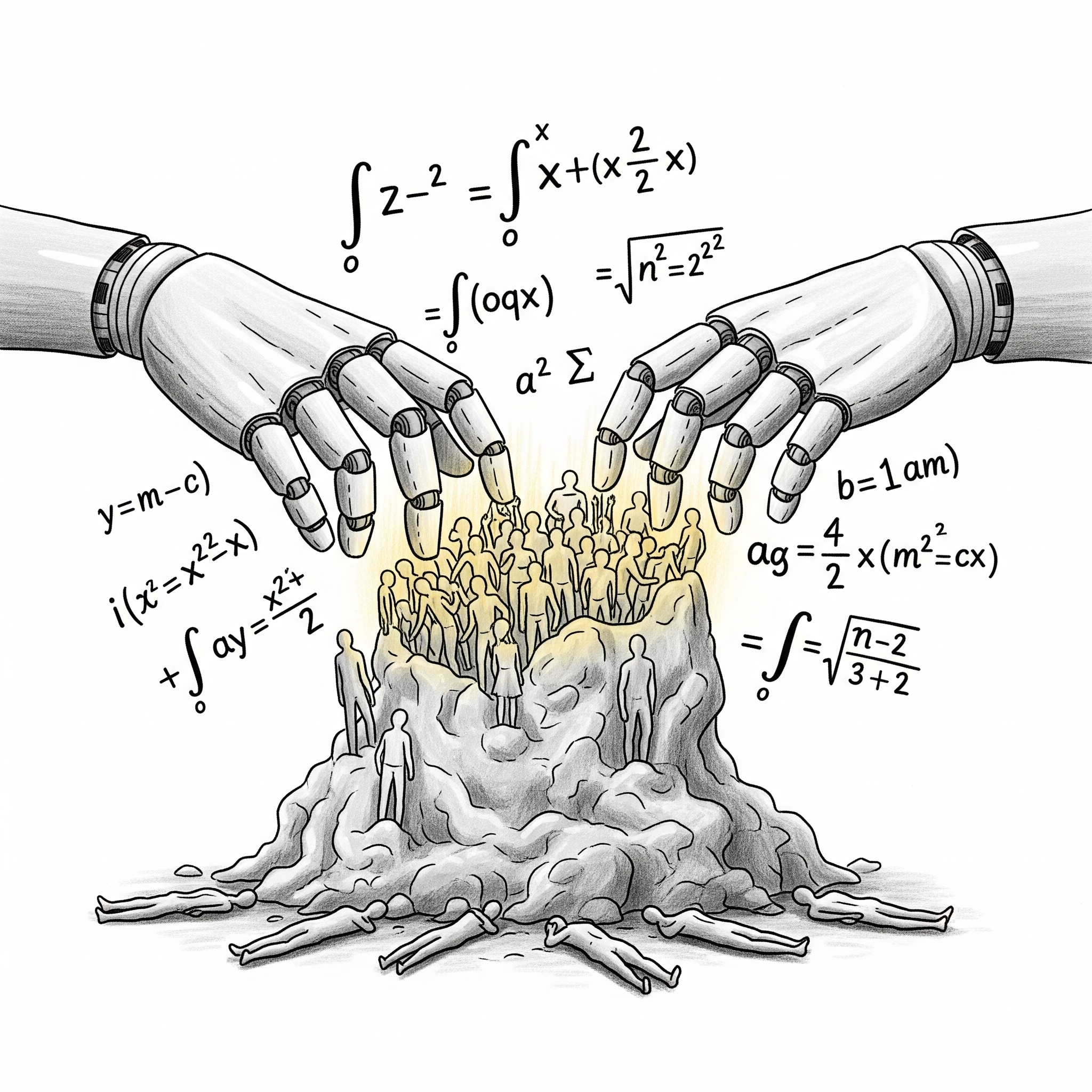

C’è un’illusione di fondo che ancora ci accompagna quando pensiamo ai numeri, alle formule, agli algoritmi: quella di una matematica “neutrale”, distaccata, quasi al di sopra dei pregiudizi umani. Cathy O’Neil, con il suo libro “Armi di distruzione matematica”, demolisce questa illusione pezzo dopo pezzo, e lo fa con una chiarezza e una passione che davvero costringono a rimettere in discussione tutto ciò che pensavamo di sapere sul potere dei dati.

Per chi non l’avesse ancora letto – consigliamo vivamente di farlo, magari anche solo per farsi due domande scomode davanti alla prossima richiesta di “accetta i cookie” – O’Neil parte proprio dal suo percorso personale. Matematica di formazione, finita tra hedge fund e startup tech, lei per prima aveva creduto che più numeri significasse più giustizia. Invece, a Wall Street, ha visto i modelli matematici gonfiare la bolla dei subprime, amplificare rischi e ingiustizie, e, paradossalmente, fornire una giustificazione “scientifica” a decisioni che poi, di scientifico, avevano ben poco.

La cosa che colpisce è come i modelli, una volta usciti dai laboratori e dalle simulazioni accademiche, si siano infilati in ogni anfratto della società. Oggi li troviamo ovunque: dalla scuola ai tribunali, dalle banche alle pubblicità che ci inseguono online. E non solo: decidono chi riceverà un prestito, chi sarà chiamato per un colloquio, chi verrà licenziato, chi dovrà pagare di più per l’assicurazione auto, chi sarà sorvegliato da una pattuglia di polizia. Sembra il set di un film distopico, e invece è la routine di ogni giorno.

Leggendo O’Neil sorge una domanda semplice e spiazzante: quando un modello matematico diventa pericoloso? Non basta dire “quando sbaglia”, perché anche un modello ben fatto può sbagliare di tanto in tanto. Il problema nasce, piuttosto, quando un algoritmo si fa opaco, si applica su vasta scala e produce danni sistemici, colpendo soprattutto chi ha meno mezzi per difendersi. Un po’ come una burocrazia impazzita: fredda, senza volto, incapace di ascoltare. Lì, sì, che diventa un’arma – un’arma di distruzione matematica.

Un esempio raccontato – che resta in testa come una piccola ingiustizia che nessuno ha voglia di raccontare – è la storia di Sarah Wysocki, insegnante a Washington. Amata da studenti e genitori, si vede licenziata all’improvviso perché un algoritmo, il famoso IMPACT, l’aveva bollata come “tra i peggiori docenti”. Poco importa se il modello, a monte, era fallato (bastava che l’anno prima fossero stati truccati i risultati dei test degli studenti per falsare tutto). Poco importa il contesto reale, la storia personale, la voce di chi la conosceva davvero. Il numero parla, il destino si compie. E nessuno che possa contestare, spiegare, nemmeno appellarsi. Così nasce il circolo vizioso: più il modello punisce, più la gente impara a “giocare con le regole” – truccando dati, aggirando ostacoli – e meno il sistema assomiglia a ciò che dovrebbe valutare.

Poi ci sono storie più quotidiane ma ugualmente inquietanti, come quella del credit scoring usato nei colloqui di lavoro. Negli Stati Uniti (ma attenzione, la tendenza si sta diffondendo anche altrove), molte aziende ora stanno controllando il punteggio di affidabilità creditizia anche prima di assumere. Così, chi parte già da condizioni svantaggiate – magari per colpe non sue – si trova chiuso fuori dal mercato del lavoro. Il meccanismo, alla fine, è quello della doppia pena: povero perché non hai credito, senza credito perché sei povero, e intanto l’algoritmo, come un giudice invisibile, inchioda il futuro a un numero.

O’Neil ci mette in guardia: ogni volta che un modello decide sulla base di “proxy” (cioè sostituti di dati veri, come il codice postale al posto del rischio reale, o il test standardizzato al posto della qualità educativa), siamo in zona rossa. Nel baseball, ci ricorda, le statistiche funzionano perché ogni dato riflette azioni concrete (un punto segnato, una palla mancata). Ma quando si passa dalla palla al campo sociale, i proxy diventano pericolosi: il codice postale riflette la povertà e, di riflesso, la razza; i punteggi dei test riflettono il contesto familiare, non solo l’impegno. Così l’algoritmo, travestito da giudice imparziale, diventa lo specchio dei nostri pregiudizi.

Un altro mito che O’Neil smonta senza pietà è quello del “più dati uguale più verità”. Anzi, ci ricorda che ogni modello è una semplificazione, e che senza feedback, senza la capacità di correggersi quando sbaglia, rischia solo di cristallizzare gli errori. Prendi le classifiche delle università americane – veri e propri totem per studenti e famiglie, al punto che le strategie degli atenei vengono dettate da punteggi decisi da una redazione di rivista. E allora via a gonfiare le statistiche, tagliare i corsi meno redditizi, investire in palestre e campus di lusso per salire in classifica. Il vero senso dell’educazione? Quello rischia di perdersi per strada.

E poi c’è il mondo della pubblicità online, che di neutrale non ha nulla. O’Neil ci porta dietro le quinte delle università “for-profit”, quelle che campano reclutando studenti fragili – madri single, disoccupati, reduci di guerra – promettendo miraggi di successo e lasciandoli solo con una montagna di debiti. La pubblicità mirata, in questo contesto, diventa una macchina perfetta di propaganda e selezione delle vittime: gli algoritmi scelgono chi colpire sulla base di dati che nessuno controlla, chi sta in cima al sistema incassa, chi sta in basso paga il prezzo, e spesso nemmeno si accorge di essere stato preso di mira da una “macchina”.

Le stesse dinamiche si trovano nella giustizia: polizia predittiva, sistemi di valutazione del rischio di recidiva, sorveglianza capillare. Prendi PredPol, il software che promette di “prevenire il crimine” (a Minority Report ci stiamo arrivando) indirizzando le pattuglie dove il rischio è più alto. A parole, tutto neutrale. Ma nella pratica, chi viene sorvegliato di più è chi vive nei quartieri poveri, e così più polizia produce più segnalazioni, che producono più dati, che rafforzano la sorveglianza. Il rischio di automantenere un pregiudizio – razziale, sociale – è enorme. E peggio ancora, spesso la persona non sa nemmeno di essere giudicata da un algoritmo; non può difendersi, non può discutere, non può nemmeno sapere cosa l’ha condannata. È una sorta di tribunale segreto, in cui l’accusato non può parlare.

Nel lavoro, la musica non cambia. Dai test di personalità automatizzati per le assunzioni (che finiscono spesso per discriminare chi ha storie di malattia o semplicemente risponde fuori dagli schemi) ai software che programmano i turni di lavoro nei negozi, l’algoritmo diventa il nuovo portiere, spesso più severo e meno trasparente di quelli in carne e ossa. O’Neil racconta il caso di Kyle Behm, scartato sistematicamente da supermercati perché i test psicometrici lo bollavano come “inadatto”. Nessuno che possa spiegare o correggere. Eppure, dietro la facciata dell’imparzialità, si nascondono nuove forme di esclusione sociale: chi è già fragile rischia di rimanere tale a tempo indeterminato, chi è diverso dal “modello vincente” dell’azienda viene messo da parte senza diritto di replica.

Interessante è notare come queste forme di automazione colpiscano soprattutto i più deboli: i lavori a basso salario, i candidati meno istruiti, le minoranze. La promessa di una valutazione scientifica ed equa svanisce se il sistema premia solo chi già parte avvantaggiato. E chi pensa che basti “avere il giusto profilo” per essere al sicuro, forse dovrebbe chiedersi quanto sia giusto vivere in un mondo in cui il prossimo “update” dell’algoritmo potrebbe ribaltare tutto senza preavviso.

Nella sua opera O’Neil illustra come sul posto di lavoro, poi, la logica dell’ottimizzazione continua porta ad esempio a turni spezzettati, orari impossibili da conciliare con la vita familiare o stress cronico. Il termine “clopening”, usato per chi fa chiusura serale e apertura mattutina nello stesso locale, è ormai familiare a molti commessi e camerieri. Tutto questo per inseguire l’efficienza massima – ogni minuto, ogni ora deve produrre qualcosa – ma chi paga davvero sono le persone, che vedono evaporare la possibilità di organizzarsi, di prendersi cura dei figli, di vivere serenamente. I sistemi che dovrebbero aiutare finiscono per trasformarsi in strumenti di controllo e di precarietà.

Anche i "colletti bianchi" non sono immuni: software come quelli sviluppati da Cataphora (che analizzano email e scambi digitali per mappare l’innovazione e decidere chi licenziare) rischiano di ridurre la ricchezza umana a una manciata di dati quantitativi. E se il tuo contributo non si vede nel grafico, poco importa: puoi essere tagliato senza che nessuno sappia davvero cosa hai portato all’azienda. La tentazione di “scaricare la colpa sull’algoritmo” è forte, e per chi subisce il danno, è quasi impossibile reagire.

A livello di società, come ci racconta O’Neil nel contesto statunitense, il meccanismo si ripete anche nel settore finanziario. Il credito, un tempo assegnato a discrezione di funzionari spesso prevenuti, è stato “democratizzato” dal punteggio FICO, basato su dati oggettivi. Un progresso, finché non è arrivata la nuova generazione di “e-scores”, punteggi opachi costruiti su dati aggregati dai social, dagli acquisti online, dalla cronologia web. Nessuno sa davvero come funzionino, nessuno può correggere errori, e spesso si finisce per essere valutati sulla base di variabili che non hanno nulla a che vedere con il proprio merito individuale. Sembra quasi che il vecchio “redlining” sia tornato in versione digitale: se vivi in un certo quartiere, se hai certi amici, se non compri certi prodotti, rischi di essere escluso senza saperlo.

E mentre in Europa qualcosa si muove (il GDPR offre alcune tutele, benché perfettibili), negli Stati Uniti il mercato dei dati personali è ancora un far west: aziende che comprano e vendono profili comportamentali senza che tu possa dire la tua, errori che si propagano nei sistemi senza possibilità di rettifica, discriminazioni che passano inosservate perché “automatiche”. O’Neil mostra con esempi concreti come le conseguenze siano spesso grottesche: chi paga l’assicurazione auto può trovarsi premi maggiorati non per come guida, ma per il proprio credit score. Se sei povero, paghi di più, e la spirale della povertà si rafforza. Oppure pensiamo ai sensori di fitness e ai programmi di wellness aziendale: strumenti pensati per migliorare la salute finiscono per fornire alle aziende un tesoro di dati intimi, che potrebbero diventare un domani criteri di selezione per assunzioni e promozioni. Un “health score” troppo basso e rischi di essere scartato, magari senza nemmeno saperlo.

C’è poi il tema della cittadinanza e della democrazia. Sì, perché gli algoritmi non si fermano alla sfera privata: influenzano ciò che vediamo nei feed dei social, quali notizie ci raggiungono, come vengono indirizzate le campagne elettorali. Il caso dell’esperimento di Facebook – mostrare o meno il box “Hai votato?” agli utenti, spingendo (scientificamente!) migliaia di persone in più alle urne – è solo la punta dell’iceberg. Gia oggi viviamo gli effetti delle distorsioni sempre maggiorni a fini politici per mezzo di questi strumenti. Se la personalizzazione delle informazioni portasse a una società di “bolle informative” in cui ciascuno vive nella propria realtà parallela? Il rischio che la democrazia stessa sia manipolata da logiche algoritmiche invisibili è reale, e O’Neil suona l’allarme senza mezzi termini.

A questo punto, viene spontaneo chiedersi: “Tutto questo riguarda davvero anche l’Italia, oppure è solo roba d’oltreoceano?” Siamo meno avanti di Stati Uniti e Cina nell’automazione selvaggia delle decisioni, ma la nostra quotidianità sta già da tempo sperimentando forme più o meno occulte di “giudizio algoritmico”.

Prendiamo il caso emblematico dell’INPS e del cosiddetto “algoritmo dei navigator” durante il Reddito di Cittadinanza: il sistema, pensato per abbinare offerte di lavoro ai beneficiari, ha mostrato limiti enormi nel valutare profili e opportunità, spesso producendo risultati casuali o insensati, tanto che la Corte dei Conti (2023) ha evidenziato le lacune del matching automatico nelle sue relazioni.

Sempre nel settore del lavoro una vicenda esemplare è quella di Deliveroo. La piattaforma di food delivery utilizzava un algoritmo (denominato Frank) per gestire le prenotazioni delle sessioni di lavoro dei rider, assegnando priorità in base a un punteggio reputazionale di “affidabilità” e “partecipazione”. Il funzionamento preciso del modello era opaco, l’azienda non ha divulgato i criteri, ricostruiti solo grazie alle testimonianze dei rider. In pratica, il sistema penalizzava in modo uniforme qualsiasi cancellazione tardiva di un turno, senza considerare i motivi. Ciò significava che un rider veniva declassato nel ranking anche se rinunciava a una consegna per causa di forza maggiore, ad esempio sciopero, guasto, incidente o un malessere. Trattando allo stesso modo assenze giustificate e non, l’algoritmo finiva per discriminare indirettamente i lavoratori riducendo le loro opportunità di prenotare le fasce orarie più redditizie. Nel 2020 il Tribunale di Bologna ha riconosciuto questo effetto distorsivo condannando Deliveroo per condotta illegittima nei confronti dei rider.

Anche nel mondo della scuola italiana si è verificato un caso tipico di algoritmo dagli effetti perversi. Nel 2016, a seguito della riforma detta “Buona Scuola”, il Ministero dell’Istruzione ha utilizzato un sistema automatizzato per gestire la mobilità di oltre 100 mila insegnanti su tutto il territorio nazionale. L’obiettivo era assegnare le sedi in base a punteggi di servizio e preferenze, ma il risultato è stato caotico: migliaia di docenti con punteggi alti sono stati trasferiti lontano da casa, spesso dal Sud al Nord, mentre cattedre più vicine venivano attribuite a colleghi con punteggi inferiori. L’“algoritmo impazzito”, come fu ribattezzato, presentava errori e criteri oscuri, generando proteste diffuse per le ingiustizie e disagi familiari causati. In seguito, una sentenza del TAR del Lazio ha censurato duramente quel sistema, definendolo un “metodo orwelliano” in cui una decisione così delicata era lasciata a un algoritmo non supervisionato. I giudici hanno evidenziato che il software operava in modo confuso e lacunoso, basato su dati inseriti male, e soprattutto che non rispettava il merito.

In campo finanziario, gli algoritmi di credit scoring – usati da banche e finanziarie per decidere a chi concedere un prestito e a quali condizioni – possono generare discriminazioni indirette verso determinate categorie. In Italia sono emerse evidenze di bias soprattutto nei confronti dei clienti immigrati. Studi recenti condotti anche dalla Banca d’Italia hanno rilevato che, a parità di caratteristiche socio-economiche, un richiedente straniero ha una probabilità di vedersi rifiutare un mutuo più alta di circa 2-3 punti percentuali rispetto a un pari profilo italiano. Inoltre, anche quando il finanziamento viene erogato o viene dimostrata una storia creditizia solida, ai clienti non nativi spesso tocca un tasso d’interesse leggermente superiore (in media pochi decimali in più) rispetto ai mutuatari italiani. Questa disparità suggerisce che gli algoritmi utilizzati incorporano variabili o dati proxy correlati con l’origine etnica/nazionale.

Anche nella pubblica amministrazione italiana si stanno affacciando sistemi di punteggio algoritmico dei cittadini che hanno sollevato dibattito. Ispirandosi (inconsapevolmente) al discusso modello di “credito sociale” cinese, alcuni enti locali hanno proposto di premiare con punti i comportamenti virtuosi dei residenti. Ad esempio Roma ha testato lo Smart Citizen Wallet, un portafoglio digitale dove i cittadini accumulano crediti se usano mezzi pubblici o riciclano correttamente; il Comune di Bologna ha ipotizzato un sistema simile di incentivi per chi adotta stili di vita “green”, dalla mobilità sostenibile alla differenziata. Il caso più estremo è però quello di Fidenza: qui l’amministrazione ha introdotto un meccanismo a punti per gli inquilini delle case popolari, valutandone il comportamento sociale. I destinatari degli alloggi ottengono bonus o malus e possono persino essere sfrattati se perdono tutti i punti accumulati negativamente. L’intento dichiarato è responsabilizzare e incoraggiare il rispetto delle regole condominiali, ma una simile misura rischia di colpire proprio i più fragili. Iniziative del genere infatti premiano chi può permettersi comportamenti “virtuosi”. Senza un opportuno contesto di supporto (migliori trasporti pubblici, politiche sociali, dialogo con i cittadini), questo “rating civico” finisce per amplificare le disuguaglianze: per di più raccogliendo una mole di dati personali sui cittadini. Non sorprende quindi che il Garante Privacy e varie associazioni abbiano espresso allarme su questi progetti, evidenziando il rischio di derive antidemocratiche e chiedendone una revisione prima di una loro eventuale attuazione su larga scala.

A leggere tutto questo, verrebbe da cedere allo sconforto. E invece il libro di O’Neil è, paradossalmente, un invito a reagire. Non a demonizzare la tecnologia, sia chiaro – lei stessa, da matematica, ama la disciplina e sa quanto bene può fare quando è usata con consapevolezza e responsabilità. Il punto è non delegare alla matematica (o meglio, a chi la scrive in codice) il compito di decidere cosa è giusto e cosa no. Serve trasparenza, sì, ma serve soprattutto coscienza collettiva. Perché ogni algoritmo nasce da scelte umane – da un’idea di successo, da una definizione di “merito”, da una scala di valori. Se quei valori sono mal definiti o ciechi rispetto alle diversità reali, allora anche il modello più sofisticato diventa una gabbia, e la matematica smette di essere un’amica della giustizia.

Forse è il momento di pensare a una “deontologia degli algoritmi”, come suggerisce O’Neil: un codice etico per chi scrive, addestra, implementa sistemi che incidono sulle vite delle persone. Immagina se ogni data scientist dovesse giurare, come un medico, di “non nuocere”. Sì, sembra idealistico, ma l’alternativa è rassegnarsi a una società in cui nessuno sa davvero perché le cose gli capitano – se hai ottenuto un mutuo, se sei stato scartato da un lavoro, se hai ricevuto una pubblicità mirata proprio nel giorno di maggiore fragilità.

Certo, la soluzione non può essere solo individuale. O’Neil fa notare che senza organismi di controllo pubblici – senza “auditor degli algoritmi”, senza regole chiare su cosa si può e non si può automatizzare – rischiamo di inseguire i problemi senza mai affrontarli davvero. L’Europa con l'AI Act si sta provando ad andare in questa direzione, ma sarebbe ora di pensare a istituzioni che vigilino sui modelli ad alto impatto sociale con la stessa serietà con cui si controllano i farmaci o le banche.

Una nota finale, ma che finale non è: l’arma di distruzione matematica, in fondo, non è altro che la matematica privata del suo feedback umano, cieca al contesto, sorda ai casi particolari, indifferente alla storia. Per renderla innocua – o meglio, per trasformarla in un’alleata – serve reintegrare nel processo decisionale le persone, le loro voci, la possibilità di spiegare e correggere. Non tutto può essere ridotto a numero, e la democrazia si misura anche da quanto riesce a difendere questa irriducibile complessità.

Non ci sono risposte facili, ma c’è una certezza: il dibattito va portato fuori dai circoli degli esperti, reso materia di educazione civica e di conversazione pubblica. Gli algoritmi sono troppo importanti per essere lasciati solo ai tecnici, troppo pervasivi per essere ignorati. Se non vogliamo che diventino la nuova burocrazia inespugnabile del XXI secolo, serve un nuovo patto tra scienza, società e diritti umani. E serve subito.

«i modelli non sono altro che opinioni scritte nel linguaggio della matematica» cit.

Forse la vera domanda non è se gli algoritmi siano “buoni” o “cattivi”, ma se siamo ancora capaci – come società – di discuterne insieme, di pretendere che restino strumenti al nostro servizio, e non il contrario. O’Neil con le sue indagini accende la luce in una stanza che sembrava perfettamente in ordine, e ci mostra la polvere sotto il tappeto. Ora, a noi decidere cosa farne.

Questo post è parte della rubrica TrAIettorie di cui potete trovare l'indice completo qui.